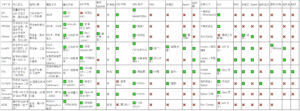

| LLM工具 | LM Studio | GPT4All | Ollama | LocalAI | AnythingLLM | Dify | ComfyUI | Text Generation WebUI | vLLM |

| 核心定位 | 轻量级本地 LLM 交互工具,图形化操作 | 开源本地 LLM 运行框架,支持多平台 | 命令行本地 LLM 管理工具,支持 API | 灵活本地 LLM 运行框架,支持 CPU/GPU | 私有知识库管理(RAG 优化) | 企业级 AI 应用开发平台(低代码) | 节点式 Stable Diffusion 工作流工具 | 本地 LLM 交互式 Web 界面 | 高性能 LLM 推理框架(生产级) |

| 适用人群 | 非技术用户、个人实验者 | 开发者和研究者 | 开发者、技术爱好者 | 开发者、企业 | 企业、个人知识管理 | 企业开发者、AI 工程师 | AI 图像生成用户 | 开发者、AI 爱好者 | 企业、高并发需求 |

| 模型格式 | GGUF | GGML、GGUF | GGUF、自有格式 | GGUF、PyTorch、Safetensors | 依赖底层框架(如 Ollama) | 支持多种格式(HuggingFace、GGUF 等) | CKPT、Safetensors | GGUF、GPTQ、AWQ | PyTorch、HuggingFace 格式 |

| 量化支持 | ✅(仅 GGUF) | ✅(4-bit/8-bit) | ✅(支持多种量化) | ✅(支持多种量化) | 取决于底层模型 | 取决于底层模型 | ✅(支持 FP16/INT8) | ✅(多种量化方案) | ✅(FP16/INT8) |

| API 支持 | ❌(无原生 API) | ✅(有限 REST API) | ✅(REST API,端口 11434) | ✅(兼容 OpenAI API) | ✅(文档检索 API) | ✅(全功能 API + 工作流) | ✅(自定义 API) | ✅(OpenAI 风格 API) | ✅(高性能 OpenAI API) |

| 兼容 OpenAI API | ❌ | ❌ | ✅(部分兼容) | ✅ | ❌ | ✅ | ❌ | ✅ | ✅ |

| 扩展性 | 低 | 中 | 高 | 高 | 中 | 极高 | 中 | 高 | 极高 |

| CPU 支持 | ✅ | ✅ | ✅ | ✅ | ✅ | ✅ | ❌(推荐 GPU) | ✅ | ❌(需 GPU) |

| GPU 加速 | ✅(Metal/CUDA) | ✅(有限) | ✅(自动检测) | ✅(CUDA/ROCm) | ✅(依赖底层模型) | ✅(需配置) | ✅(CUDA) | ✅(CUDA) | ✅(优化 CUDA) |

| 多模态 | ❌ | ❌ | ❌ | ✅(图像/语音) | ❌ | ✅(插件) | ✅(图像) | ❌ | ❌ |

| Agent | ❌ | ❌ | ✅(需代码) | ✅ | ❌ | ✅ | ❌ | ❌ | ❌ |

| 知识库 | ❌ | ❌ | ❌ | ✅ | ✅ | ✅ | ❌ | ❌ | ❌ |

| 安装方式 | 一键安装(Win/macOS) | 下载安装包 | 命令行安装 | Docker / 源码编译 | Docker / 本地安装 | Docker Compose | 免安装包 / Python | Python 安装 | Pip / Docker |

| GUI | ✅ | ✅ | ❌(需第三方前端) | ❌(API 优先) | ✅ | ✅(Web 界面) | ✅(节点式 UI) | ✅(Web 界面) | ❌(API 优先) |

| RAG | ❌ | ❌ | ❌ | ✅ | ✅ | ✅ | ❌ | ❌ | ❌ |

| 多模态 | ❌ | ❌ | ✅(插件) | ✅ | ✅ | ✅ | ✅ | ❌ | ❌ |

| 图形生成 | ❌ | ❌ | ❌ | ❌ | ❌ | ❌ | ✅ | ❌ | ❌ |

| 语音/视频 | ❌ | ❌ | ❌ | ✅(Whisper) | ❌ | ✅ | ❌ | ❌ | ❌ |

| MCP | ❌ | ❌ | ❌ | ❌ | ❌ | ✅ | ❌ | ❌ |