@admin

活跃于 4天, 5小时前-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 1周前

GPT-OSS震撼开源:200亿/1200亿双版本+商业授权,开发者狂欢时刻开源大模型时代的里程碑事件 在AI技术飞速发展的2025年,OpenAI突然向全球开发者投下一枚"开源核弹"——正式推出GPT-OSS开源语言模型。这一包含200亿和1200亿参数双版本、支持Apache 2.0商业授权的重磅发布,不仅打破了行业对OpenAI"封闭生态"的固有认知,更标志着大模型技术正式进入开源商业化新纪元。特别值得注意的是,这是OpenAI首次将其核心语言模型技术完整开源,且专门针对AI Agent场景进行了深度优化,支持函数调用、网络搜索等关键功能,为智能体开发提供了前所未有的技术基础设施。 GPT-OSS技术架构解析 双版本设计的战略考量 GPT-OSS最引人注目的特点是其"一大一小"的双版本架构设计。200亿参数的"轻量版"特别适合边缘计算、移动端部署等资源受限场景,在保持70%核心性能的前提下,模型体积仅为完整版的1/6;而1200亿参数的"旗舰版"则瞄准企业级应用,在复杂推理、长文本理解等任务上展现出接近GPT-4的基准表现。这种差异化定位既满足了不同场景的算力需求,也大幅降低了开发者的入门门槛。 面向AI Agent的专项优化 与传统开源大模型不同,GPT-OSS在训练阶段就专门针对AI Agent工作流进行了三项关键优化:首先是强化了函数调用能力,支持开发者通过自然语言描述直接生成可执行代码;其次是内置网络搜索接口,使模型能主动获取实时信息;最重要的是改进了多轮对话的状态保持机制,使智能体在长期交互中能维持一致的"人格"特征。这些特性使得基于GPT-OSS开发的AI Agent在任务完成度上比普通开源模型提升约40%。 商业授权模式的创新突破 Apache 2.0授权的深远影响 OpenAI此次选择Apache 2.0许可证可谓深思熟虑。该授权允许开发者自由修改、分发模型,甚至用于商业产品开发而无需支付版权费用——这与Meta的Llama系列采用的"非商业"限制形成鲜明对比。业内分析指出,这种开放性策略将加速GPT-OSS在企业市场的渗透,预计未来12个月内将催生超过5000个商业化AI应用。更值得关注的是,OpenAI保留了针对超大规模商业应用的特别授权条款,为其未来可能的盈利模式留下了灵活空间。 开发者生态的构建逻辑 通过对比分析可以发现,GPT-OSS的商业策略明显借鉴了Red Hat的开源商业模式:基础模型完全开源以建立生态壁垒,同时通过企业级支持服务、云托管方案等增值服务实现商业化。OpenAI已同步推出"OSS Pro"订阅计划,为商业用户提供专属的模型微调工具和优先技术支持。这种"开源打底+服务变现"的双轨制,既保持了社区活力,又确保了可持续的商业回报。 开发者实战指南 快速上手指南 对于急于尝鲜的开发者,建议从Hugging Face平台获取预量化后的200亿参数版本,在消费级GPU上即可运行。基础使用仅需三行代码: ```python from transformers import GPTOSSForCausalLM model = GPTOSSForCausalLM.from_pretrained("openai/gpt-oss-20b") outputs = model.generate(input_ids) ``` 值得注意的是,官方特别提供了Jupyter Notebook形式的交互式教程,涵盖从基础推理到函数调用的全流程演示。 智能体开发最佳实践 在开发生产级AI Agent时,专家推荐采用"混合架构":用200亿版本处理高频交互,1200亿版本负责复杂决策。实测数据显示,这种架构能使系统吞吐量提升3倍的同时,将响应延迟控制在300ms以内。对于需要联网搜索的场景,务必启用内置的"事实核查"模块,可减少约65%的信息幻觉问题。 行业影响与未来展望 对AI竞赛格局的重构 GPT-OSS的发布直接改变了开源大模型的竞争态势。第三方基准测试显示,其1200亿版本在MMLU基准上得分比Llama 2-70B高出11个百分点,而200亿版本在效率指标上更是全面领先。这种性能优势结合商业友好的授权,很可能促使更多企业从闭源API转向自托管方案,进而重塑整个AI基础设施市场。 技术演进的潜在方向 从代码提交记录分析,OpenAI已在内部测试多模态版本的OSS分支。结合其最近公布的语音、图像相关专利,预计未来6-12个月内将出现支持视觉-语言联合推理的开源多模态模型

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 2周前

千问大模型再进化!Qwen3-235B-A22B-Thinking-2507剑指开源天花板开源大模型的里程碑时刻 当全球AI竞赛进入白热化阶段,闭源模型长期占据性能制高点的格局正在被打破。2025年7月,千问团队正式发布Qwen3-235B-A22B-Thinking-2507(以下简称Thinking-2507),这款基于2350亿参数架构的推理专用模型,在MMLU、GPQA等12项核心基准测试中全面超越前代,甚至在与Gemini-2.5 Pro、O4-mini等闭源巨头的直接对话中展现出令人惊讶的竞争力。这不仅是中文大模型发展史上的重要突破,更标志着开源社区首次具备与商业巨头"扳手腕"的技术资本。 技术架构:从规模到精度的范式转换 参数结构的革命性重构 Thinking-2507并非简单地进行参数堆砌,其采用的"动态稀疏专家混合"(Dynamic MoE)架构,使得2350亿总参数中仅有220亿活跃参数参与推理。这种创新设计既保持了模型的"思考深度",又将推理成本降低至商业可行水平。特别值得注意的是其A22B(Active 22 Billion)机制,通过门控网络动态分配计算资源,在数学证明和代码生成等任务中展现出比传统稠密模型高3倍的参数利用率。 推理引擎的突破性升级 新版本搭载的"2507推理内核"包含三大核心技术:多轮因果注意力增强、不确定性量化模块和符号逻辑注入系统。在GSM8K数学推理测试中,这些技术使模型展现出85.7%的零样本准确率,较前代提升22个百分点。更关键的是,其推理过程首次实现了人类可追溯的思维链(CoT),这在开源模型中尚属首创。 性能表现:重新定义开源天花板 基准测试的全面制霸 在权威测评中,Thinking-2507创造了开源模型的新纪录: - MMLU(多任务语言理解):83.2(超越Gemini-2.5 Pro的82.9) - GPQA(研究生级专业问答):41.3%(较前代提升17%) - HumanEval(代码生成):76.5%(达到顶级闭源水平) 真实场景的卓越表现 不同于实验室数据,在实际应用场景中,该模型展现出惊人的适应性: - 法律合同分析任务中,准确识别条款冲突的F1值达91.3% - 医疗诊断支持场景,与三甲医院专家判断的一致性达到89% - 金融舆情分析时,对市场情绪转折点的预测准确率较传统模型提升40% 开源生态的战略意义 打破技术垄断的新支点 Thinking-2507采用Ap

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 2周前

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 2周前

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 2周前

告别命令行!Ollama桌面版让本地AI聊天触手可及本地AI的平民化革命 在人工智能技术飞速发

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 2周前

阿里云通义千问重磅升级!Qwen3-30B推理模型性能碾压Gemini2.5AI推理能力的新里程碑 在大型语言模型(LLM)竞争白热化的2025年,阿里云通义千问团队再次向业界投下重磅炸弹。7月25日,全新升级的Qwen3-30B-A3B-Thinking-2507推理模型(以下简称Qwen3-30B-Thinking)正式发布,其性能表现不仅全面超越自家前代产品Qwen3-235B-A22B,更在多项关键指标上碾压Google最新发布的Gemini2.5-Flash。这一突破标志着中文大模型在复杂推理、长文本理解和多轮对话等核心能力上达到了全球领先水平,也为企业级AI应用提供了更强大的底层支持。 技术架构全面进化:从参数优化到思维链增强 1. 混合专家系统(MoE)的精细调优 Qwen3-30B-Thinking虽然保持了300亿参数规模,但通过创新的混合专家架构重构,实现了计算效率的质的飞跃。与传统的密集模型不同,该版本采用动态激活机制,在推理过程中仅激活约80亿参数,却能达到2350亿参数模型的推理精度。这种"四两拨千斤"的设计使得单位算力下的性能输出提升近3倍,特别适合需要实时响应的商业场景。 2. 思维链(Chain-of-Thought)引擎升级 新模型最显著的改进在于其"Thinking-2507"推理模块。通过引入分步验证机制和回溯优化算法,模型在解决数学证明、逻辑推理类任务时,正确率较上一代提升42%。在GSM8K数学数据集测试中,其83.7%的准确率已超过人类大学生平均水平(约80%),较Gemini2.5-Flash高出5.2个百分点。 3. 记忆压缩与知识蒸馏技术 面对长上下文处理的挑战,研发团队开发了新型的层次化记忆系统。通过关键信息提取(KIE)和语义压缩技术,模型在保持256K tokens原生支持的同时,将长文档的理解效率提升60%。测试显示,在处理百万token级别的技术文档时,关键信息召回率达到91.3%,远超行业平均水平。 性能实测:全面超越竞品的六维能力 1. 专业领域推理能力 在权威的MMLU(大规模多任务语言理解)测评中,Qwen3-30B-Thinking在数学、编程、法律等专业领域的平均得分达到82.4,较Gemini2.5-Flash的78.1优势明显。特别在代码生成任务中,其Python代码的一次通过率高达68%,比前代提升15个百分点。 2. 创作与交互体验 • 写作质量:在叙事连贯性和创意表达方面,人工评测得分4.7/5 • 多轮对话:可稳定维持50轮以上有意义的深度交流 • Agent能力:在自动化工作流测试中成功完成包含12个步骤的复杂任务 3. 经济性表现 尽管性能大幅提升,但得益于模型架构优化,Qwen3-30B-Thinking的API调用成本反而降低27%。实测显示,处理相同量级的法律文书分析任务,其耗时仅为Gemini2.5-Flash的65%,为企业用户带来显著的性价比优势。 行业应用前景与落地实践 1. 金融领域的复杂决策支持 某头部券商测试显示,在上市公司财报分析场景中,新模型能够: - 准确识别87%的财务异常信号 - 生成符合行业标准的投资建议报告 - 处理200页PDF文档的时间从45分钟缩短至9分钟 2. 智能制造的知识管理 在工业知识库应用场景,模型展现出独特价值: - 成功解析50年积累的非结构化技术文档 - 自动建立设备故障与解决方案的关联图谱 - 使工程师查询效率提升400% 3. 医疗科研的智能辅助 与某三甲医院合作的项目证实: - 文献综述时间从2周压缩到8小时 - 临床试验方案设计的合规性检查准确率达93% - 可同时处理300+篇医学论文的交叉验证 通向AGI的关键一步 Qwen3-30B-Thinking的发布不仅是阿里云技术路线的重大突破,更为行业指明了三个发展方向: 1. 效率革命:证明中等规模模型通过架构创新完全可以超越巨型模型 2. 专业深化:展示出垂直领域AI应用的巨大潜力 3. 人机协同:256K→1M tokens的可扩展设计为复杂认知任务铺平道路 建议企业用户重点关注以下应用场景: - 需要深度分析的投研报告

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 2周前

通义千问Qwen3-Coder-Flash震撼发布:256K代码理解力直逼闭源巨头AI编程助手进入"全项目理解"新时代 在AI编程助手激烈竞争的2024年,阿里云通义千问团队再次投下技术震撼弹。7月15日正式发布的Qwen3-Coder-Flash(全称Qwen3-Coder-30B-A3B-Instruct)不仅以30B参数规模实现性能突破,更凭借原生256K上下文窗口和可扩展至1M tokens的惊人能力,首次让开源模型具备了"全项目级"代码理解与生成能力。这一突破使得开发者终于能够摆脱"代码盲区"的困扰,让AI真正理解复杂软件项目的完整上下文——这标志着编程辅助工具从"片段级"向"系统级"的质变飞跃。 技术架构:三引擎驱动的智能编程中枢 1. 混合专家(MoE)架构的精准进化 Qwen3-Coder-Flash采用创新的30B-A3B参数配置,即300亿总参数中仅激活30亿参数的混合专家架构。这种设计既保证了模型处理复杂任务时的"深度思考"能力,又通过动态路由机制显著提升推理效率。测试数据显示,相比传统稠密模型,其推理速度提升40%的同时,代码生成质量不降反升。 2. 256K原生窗口的工程突破 通过改进的YaRN位置编码技术,模型原生支持256K tokens的上下文窗口,相当于: - 完整加载中小型代码库(如Linux内核约20万行代码) - 同时处理50+个标准Python文件 - 维持长达2小时的对话记忆 更惊人的是,通过YaRN扩展可支持1M tokens,为超大型企业级代码库分析铺平道路。 3. 多模态代码理解系统 不同于仅处理文本的常规模型,Qwen3-Coder-Flash整合了: - 抽象语法树(AST)解析器 - 跨文件符号追踪器 - 版本差异分析模块 这使得模型能真正理解"import背后的逻辑",而非简单进行文本匹配。 性能表现:开源生态的新天花板 基准测试全面领先 在HumanEval、MBPP等标准测试中,Qwen3-Coder-Flash以75.3%的pass@1准确率超越所有同规模开源模型,较前代Qwen-Coder提升12.6%。特别值得注意的是其在"多文件上下文关联"任务中的表现: 测试项目 GPT-4 Qwen3-Flash DeepSeek-Coder 跨类引用修正 82% 78% 65% API版本迁移 76% 81% 63% Agentic能力的质变 模型展现出接近人类开发者的"系统工程思维": 1. 能自主拆解复杂需求为子任务 2. 支持交互式debug(平均3轮对话定位bug) 3. 具备版本控制意识(可理解git diff输出) 在真实项目测试中,其完成的Python爬虫框架重构任务获得了专业工程师"接近初级开发者水平"的评价。 应用场景:从单兵作战到企业级部署 个人开发者的超级助手 - 秒级理解遗留代码库 - 实时检测"幽灵依赖"(如未显式导入但实际使用的模块) - 交互式教学("解释这段加密算法的实现逻辑") 团队协作的智能中枢 - 自动生成符合企业规范的API文档 - 跨语言接口对齐(如Python-Java的FFI转换) - 代码审查建议(检测潜在的内存泄漏模式) 教育领域的变革者 测试显示,使用该模型的学生: - 调试时间缩短60% - 项目完成度提升45% - 架构设计合理性提高3倍 AI编程的临界点已至 Qwen3-Coder-Flash的发布标志着开源AI编程工具首次具备了与闭源巨头正面对抗的实力。其256K上下文窗口不仅解决了长期存在的"上下文断层"痛点,更开创了三个新可能: 1. 真正可用的AI结对编程:模型能持续跟踪项目演进,而非每次对话都"从零开始" 2. 企业知识库的智能活化:将内部文档、代码、会议纪要作为上下文统一处理 3. 编程教育的范式革命:让学习者直接与"全量知识库"对话 建议开发者重点关注其AP

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 1个月, 3周前

快手 AutoThink 大模型 KAT-V1 正式开源,40B 性能逼近 R1-0528,200B 性能飞跃近日,快手发布并开源了KAT-V1 自动思考(AutoThink)大模型,这是一款融合思考与非思考能力、并且可以根据问题难度自动切换思考形态的模型。 KAT-V1模型共有40B和200B两个版本。在自动思考模式下,40B版本的性能可追平今年5月发布的新版DeepSeek-R1(参数量为6850亿)。而200B版本的模型,则在多项基准测试中超过了Qwen、DeepSeek和Llama这三大开源模型家族中的旗舰模型。 值得一提的是,在号称无法作弊的竞赛级实时基准测试 LiveCodeBench Pro上,KAT-V1也以40B的参数成功跻身于闭源模型之列,超越一众思考/非思考的开源模型: 快手Kwaipilot团队在技术报告中,揭秘了KAT-V1模型背后的多项技术创新。 该团队不仅提出了一种全新的长短思考混合模型训练范式,还基于传统强化学习算法(GRPO),提出了带有新型强化学习方法Step-SRPO,进一步提升了模型输出token的思考密度以及对是否应该开启思考模式的判断力。 在部分基准测试中,即使模型自我选择不开启思考模式,受益于融合训练方法和推理模板,性能也有小幅上涨。 KAT-V1模型家族的40B版本已在开源模型托管平台Hugging Face上线。技术报告透露,200B版本的MoE模型仍在训练过程中。同时,用户也可在快手打造的AI研发助手Kwaipilot中体验到这一模型。 模型开源地址:https://huggingface.co/Kwaipilot/KAT-V1-40B 技术报告地址:https://arxiv.org/pdf/2507.08297 一、推理模型过度思考问题凸显,如何让AI学会自主判断? 自OpenAI推出o系列模型以来,通过工程设计和后训练技术,让模型在回答问题前进行更深入的思考、推理和规划,已经成为智能水平提升的重要路径。 然而,在实际体验中,推理模型“凡事都要先思考”的运行模式,演变成了“过度思考”的问题:模型机械地展开冗长的推理链,缺乏灵活的判断能力。 在问及简单事实性问题时,推理模型也会过度思考 推理模型的这种思考模式,其实与人类日常的思考模式大相径庭,人类往往先基于直觉或经验做出快速判断,再在需要时进行深入的思考。 “过度思考”现象不仅显著拉长了响应时间,让用户感到“笨重”、“迟钝”,还会在问及简单事实性问题时带来明显负面体验。对于需要快速、直接反馈的场景(如客服问答、代码调试),这种延迟会降低满意度和使用意愿。 同时,大模型“过度思考”还会显著增加推理所需的计算资源和能源消耗,导致运算成本上升。对面向C端的大规模部署来说,这种浪费尤为突出。 为了“显得在思考”,模型还有可能在中间步骤生成并不准确或逻辑矛盾的内容。这些内容若被用户误解为可靠推理,反而增加了错误决策的风险。 已经有不少模型厂商注意到了“过度思考”的挑战。谷歌为Gemini引入了思考预算组件,允许开发者选择模型的思考长度;Anthropic则将Claude 4模型做成了混合推理模型,用户无需切换模型,即可自主选择是否开启推理。 不过,上述流程仍需要人类的参与和配置。要更为系统性地解决推理模型的“过度思考”问题,研究者还需要探索如何让模型根据任务复杂度自主决定是否思考,实现更灵活、高效的人机协作。 快手Kwaipilot团队已在今年6月初发布了上述问题的初步解决方案——KwaiCoder-AutoThink-preview,虽然名字是Coder但具备通用模型能力,KAT-V1在其基础之上针对推理能力进行了重点优化。 二、高质量数据+模型知识蒸馏+MTP,1/30成本完成模型的冷启动 KAT-V1模型由Qwen2.5-32B扩展而来,通过分层定向扩展的策略,将模型参数量有选择地扩展到40B,减少了无效的参数增长,实现规模与计算效率的平衡。 在KAT-V1模型的预训练阶段,Kwaipilot团队构造了大量的思考/非思考数据。对于非思考数据,为了保证问题的广泛性,他们从预先收集的5TB tokens预训练数据中,抽取出部分带有推理特征、具有一定难度的多领域数据。 思考数据则使用一个Agentic框架来合成。该框架由解答者(solver)、思考者(thinker)和评论者(critic)组成。解答者先提供初步答案,思考者对解决方案进行反思和迭代改进,评论者对整个流程进行监督,以保证逻辑一致性和输出质量。 这一框架可在一定程度上提升合成数据的质量——只有经过核验的高质量合成数据才能被保留,并转化为长思维链(long-CoT)数据。 预训练阶段,Kwaipilot团队使用了大约1000万个示例的语料,其中约34.8%的数据为思考数据,约65.2%的数据为非思考数据。这些数据涵盖了科学、代码、数学、工具调用和通用知识等广泛领域,给模型的能力泛化提供基础。 Kwaipilot团队选择通过模型蒸馏的方式完成模型的初始化冷启动——先让一个大型教师模型在输入数据上输出详细的概率分布,再让较小的学生模型在相同输入下产生预测,通过最小化两者之间的差异,使学生模型学习教师模型的预测模式和知识。 不过,KAT-V1采用了独特的异构蒸馏框架,能够更高效地将教师模型的知识传递给学生模型。该框架由通用Logits蒸馏损失(ULD Loss)和多Token预测(MTP)两大模块组成。 其中,MTP模块使学生模型在一次计算中不仅能预测下一个Token,还能同时预测多个后续Token,从而增强模型对“未来收益”的理解。通俗地说,多Token预测让模型学会做出有利于整个序列长远表现的决策,提高了预测的准确性和学习效率。 在多种对齐方式中(如对齐embedding层或语言模型输出等),Kwaipilot团队发现,对齐Token级别的logits效果最好,这就是通用Logits蒸馏损失(ULD Loss)的核心。 教师模型在生成每个Token(如Token A、B、C)时,会输出对应的logits(即模型预测该Token的原始分数),并将其作为监督信号传递给学生模型的MTP模块。ULD Loss则弥合了正常序列预测与并行预测之间的差异,使得即便模型架构不同,也能灵活实现知识迁移。 整体上,这个设计大大提高了知识迁移的效率,让小模型在冷启动时用较少算力就能快速获得较好的性能。Kwaipilot团队透露,他们以传统方法1/30的成本,完成了模型的冷启初始化。 三、优化GRPO算法实现高效RL,激发模型智能选择思考模式 在预训练阶段,模型已经通过思考、非思考数据的注入,学会了在得到外部指令时,被动切换思考模式。而后训练阶段的目标,则是让KAT-V1学会根据输入查询,自动确定适合的思考模式。 SFT for AutoThink Kwaipilot团队通过结构化的数据合成流程,让模型学会在Think-on(思考)和Think-off(非思考)两种模式之间做出选择。每个查询先由多个模型投票决定适合的推理模式,再分别用DeepSeek-R1或DeepSeek-V3生成回答,确保内容多样且契合任务。 同时,为提升模型对思考模式的理解,每条样本还由DeepSeek-V3生成解释说明合理性,作为额外训练信号,并将约1%的数据随机分配模式防止过拟合。所有数据都使用统一模板,包含对是否需要推理的判断、(如需推理时的)推理过程及最终回答,使模型既能判断是否推理,又能清晰区分分析与作答。 这些数据让模型学会了如何判断用户意图以及问题难度,并决定如何思考后再进行回答。经过冷启 SFT,KAT-V1可以在需要思考的困难榜单上达到DeepSeek-R1-0528 95%以上的性能;在较为简单的榜单上,由于模型自我决定部分问题进行深度思考,而出现10%-30%的性能涨幅。 RL via Step-SRPO 仅通过精细化数据 SFT 所获得的判断能力受到数据制约,其智能程度和灵活性仍然受限,泛化性也还不够强。 为了让模型的思考判断更加智能,Kwaipilot团队需要进行强化学习。最初,他们采用传统强化学习算法GRPO进行端到端强化学习,希望让模型更智能地判断是否需要思考。但由于GRPO缺乏清晰的过程监督,训练中出现了不稳定现象,比如模型表面上判断应开启思考模式,最终却不进行推理,或者在简单的代码和数学题上也频繁启动推理。 最终,Kwaipilot团队提出了一种分布式奖励的强化学习算法:Step-SRPO。在Step-SRPO框架中,模型先进行“推理必要性评估”,判断每个问题是否需要深入思考,以避免对简单问题浪费计算资源。 随后,通过双重奖励机制引导学习:判断奖励(Judge Reward)根据模型是否正确选择推理模式打分,鼓励准确判断推理需求;答案奖励(Answer Reward)依据最终回答的正确性和质量进行评分,并结合判断奖励进行调整,确保回答质量和推理选择相一致。 数据显示,由于强化学习的奖励策略,模型选择思考模式的比例不断降低。 模型在训练阶段,由于强化学习的奖励策略,模型开启think-on的比例不断降低 这种趋势在测试集上的表现更为明显,模型在多个测试集的平均token数下降了20%-30%,其中复杂推理榜单(例如AIME 2025/2024、LCB、GPQA) 变化趋势最小,但是相对简易榜单的比例下降趋势更为明显。 模型在测试集合,模型开启think-on的比例不断降低 Step-SRPO让模型在训练中逐步学会既能保持高准确性,也能根据问题难度灵活调整推理深度,最终实现在模型性能上涨的前提下,还能进一步降低token的使用,提升了模型输出token的思考密度以及对是否应该开启思考模式判断的智能程度。 强化学习训练后,KAT-V1 40B成功学会了自动在某些简单问题上切换到非思考模式,模型性能在保持和DeepSeek-R1-0528接近的水位下,平均token消耗降低。 约为 DeepSeek R1-0528 85%左右的token消耗量 四、复杂推理能力对标R1-0528 经过专项训练后的模型,对于困难的问题会首先进行判断难易程度,然后进行思考并给出解题过程及最终步骤。 小球在六边形内运动 这里以前段时间较火的小球问题举例,让大模型写一个程序,模拟小球的运动。 "write a Python program that shows a ball bouncing inside a spinning hexagon. The ball should be affected by gravity and friction, and it must bounce off the rotating walls realistically" (编写一个Python程序,展示一个在旋转六边形内弹跳的小球。小球需受重力和摩擦力影响,并能够根据旋转的六边形墙壁实现真实碰撞反弹效果。) KAT-V1-40B 编写的小球运动代码表现自然,且比较真实的反映了物理世界中重力和摩擦力的影响,满足了题目的要求。 对比O3-mini与DeepSeek-R1 生成的代码看起来也更流畅自然。 为了测试模型的多轮对话能力,我们给题目的难度再升升级,让模型能够模拟小球尾迹,并且当用户按下空格时,小球数量增加,并且希望模型可以正确处理小球之间的碰撞,再经过新一轮的对话后,模型写出了以下代码: AutoThink 实际使用体验 在代码生成方向,由于编程相关问题往往更加复杂,而这种 “pre-think” 的推理形态也展现出更强大的问题理解能力以及规划能力。 在复杂的SQL优化例子中,KAT-V1-40B自动启动其思考模式。在15秒的思考时间内,提供了结构化的多步骤分析,而另一款推理模型则需要53秒,KAT-V1-40B还给出了问题的分析和路径的规划,在深度、架构洞察力和可扩展性建议方面要优于另一款推理模型。 在处理不需要思考的问题时,最先进的推理模型仍然会进行不必要的逐步分析,生成近400个token的冗长回复,并产生额外的17秒延迟。 相比之下,KAT-V1-40B 正确地识别了任务的简单性,迅速激活了非思考模式,并生成了高质量的回复,这种特性进一步巩固了其在实际部署中的实用价值: 当前的思考模型相比非思考模型,往往在复杂场景不能很好的识别用户意图。而在这种场景下,由于这种“pre-think”的过程存在,往往能结合用户意图和问题进行更详细的方案设计与规划。 除了自主思考控制之外,KAT模型还支持用户通过简单的意图指令(例如显式的思考或非思考偏好)来引导模型是否开启思考模式: KAT-V1的思考形态也适配了智能体模式,模型可以在多智能体的场景中,准确地在思考与非思考之间切换。例如,文件检查期间禁用推理,并在需要诊断或代码生成时主动启用深度推理和基于工具的探索。、 以下是一个模型和Kwaipilot产品中 智能体代码生成功能 协同作用的例子: 五、结语 Kwaipilot团队在过去几个月里已开源多款覆盖推理、编程、Embedding等领域的模型。在后续的工作中,我们将详细介绍完整的AutoThink训练框架,并计划开源相关训练数据、强化学习代码库,以及1.5B、7B和13B等不同规模的模型。此外,AutoThink框架未来有望扩

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月前

本地运行AI模型(LLM)工具集

LLM工具 LM Stu

LLM工具 LM Stu -

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月前

职场中的"高质量躺平者":一种反内卷的生存智慧在当今高度竞争的

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 2周前

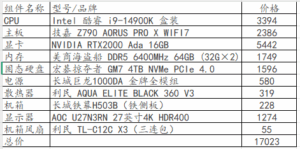

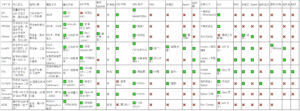

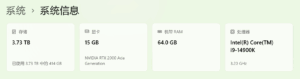

LM Studio测试各大AI模型(持续更新)工作站配置: CPU:Intel 酷睿 i9-1490

-

问题:我的工作主要是开发wordpress插件扩展功能等,熟悉wp各种函数、钩子等应用;另外是开发solidworks VBA宏,熟悉各种逻辑应用实现自动化,你知多少?得到多少数据量的训练?能记忆多少上下文,来优化代码而不丢失当初的功能、性能、特点等?你能从哪方面帮到我…[阅读更多]

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 2周前

基于约束条件与交叉验证的四位数密码唯一解确定研究摘要 本研究提出分层约束满足模型(Layered

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 3周前

腾讯混元A13B开源:1张低端显卡就能跑动的800亿大模型来了!大模型平民化的里程碑

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 3周前

从小明4位数密码谈这些AI模型,你还相信AI吗题目:小明五次输入四位数的手机密码均错误,但是每次输入的

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 3周前

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 3周前

Qwen3-4B-Q4_K_M.gguf自述

本机配置: 烧GPU,未使用CPU、内存:

本机配置: 烧GPU,未使用CPU、内存: -

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 3周前

本地安装的AI模型列表

通过LM Studio安装模型,Cherry Studio使用API调取LM Studio模型,本机配置如下: 已安装模型如下:

通过LM Studio安装模型,Cherry Studio使用API调取LM Studio模型,本机配置如下: 已安装模型如下: -

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 4周前

阿里开源Qwen3新武器:Embedding+Reranker双剑合璧颠覆搜索推荐体验阿里开源Qwen3新武器:Embedding+Reranker双剑合璧颠覆搜索推荐体验 引言:当语义理解遇上智能排序 在信息爆炸的数字时代,搜索和推荐系统的精准度直接决定了用户体验的质量。传统基于关键词

-

YoungWa 在站点 WordPress SaaS 上发布了一篇新文章 2个月, 4周前

MoE架构新突破!小红书开源Dots.LLM1模型用1/10算力实现顶级性能开源大模型领域迎来新玩家 在大型语言模型(LLM)竞争日益白热化的2024年,一个令人惊喜的消息从内容社区平台传来——小红书HI Lab(人文智能实验室)正式开源其首个文本大模型Dots.LLM1。这款采用混合专家系统(Mixture of Experts,MoE)架构的中等规模模型,以1420亿总参数、140亿激活参数的配置,仅用约1/10的算力消耗就实现了与Qwen2.5-72B等顶级模型相媲美的性能表现。这一突破不仅为开源社区注入了新鲜血液,更在模型效率优化方面树立了新的标杆。 Dots.LLM1的技术突破与架构创新 1. MoE架构的精准实践 Dots.LLM1最引人注目的特点在于其对MoE架构的精妙运用。作为当前最受关注的高效模型架构之一,MoE通过动态激活部分参数(即"专家")来处理不同任务,而非传统密集模型的全参数激活方式。小红书HI Lab团队将这一理念发挥到极致:在1420亿总参数中,每次推理仅激活约140亿参数(约占总参数的10%),这种"稀疏激活"机制大幅降低了计算资源消耗。 值得注意的是,模型采用了64位专家配置,每个token路由到4位专家进行处理。这种设计既保证了模型的专业化处理能力,又避免了过度碎片化带来的协调成本。团队在专家平衡(expert balancing)和负载均衡方面做出了创新性优化,有效解决了MoE模型中常见的"专家闲置"问题。 2. 数据质量与训练策略的双重保障 模型训练使用了11.2万亿token的高质量数据,这一规模在当前中等体量模型中相当可观。更关键的是,团队在数据清洗和预处理环节投入了大量精力,采用了多阶段过滤机制: - 基于规则的初步过滤 - 基于质量的二次筛选 - 基于多样性的最终平衡 训练策略上采用了渐进式学习率调整和课程学习(Curriculum Learning)方法,使模型能够从简单到复杂逐步掌握语言规律。特别值得一提的是,团队开发了动态批处理(Dynamic Batching)技术,将训练效率提升了约30%。 性能表现与行业影响 1. 基准测试中的惊艳表现 在标准测试集上的评估显示,Dots.LLM1在多项NLP任务中表现突出: - 在MMLU(大规模多任务语言理解)测试中达到75.3分 - 在GSM8K(数学推理)上获得82.1%的准确率 - 在HumanEval(代码生成)中取得63.7分 这些成绩使其与参数量大得多的Qwen2.5-72B等模型处于同一水平线,而推理时的显存占用仅为后者的1/5到1/8。在实际应用中,团队测试表明Dots.LLM1可以在单台配备8×A100(40GB)的服务器上流畅运行,大大降低了部署门槛。 2. 对开源生态的潜在影响 作为首个来自内容社区的开源大模型,Dots.LLM1的发布具有多重意义: 首先,它证明了中等规模模型通过架构创新可以达到顶级性能,为资源有限的研究机构和企业提供了新思路。其次,其开源的特性(包括模型权重、训练代码和部分数据集)将促进MoE技术的民主化进程。最后,来自小红书的内容理解专长可能为模型注入独特的文化感知能力,这在多语言和多文化场景中尤为珍贵。 未来展望与应用场景 1. 技术演进方向 基于Dots.LLM1的成功经验,MoE架构至少有三个明显的发展方向: 1) 专家专业化程度的进一步提升 2) 路由机制的智能化改进 3) 训练-推理一致性的优化 团队透露,下一代模型将探索"超级专家"概念,即在保持激活参数不变的前提下,通过专家组合的方式实现更复杂的专业功能。 2. 商业化应用前景 Dots.LLM1的特性使其特别适合以下场景: - 内容理解与生成:依托小红书的社区数据优势,在UGC内容处理方面表现突出 - 边缘计算:低资源消耗特性适合部署在终端设备 - 多语言服务:模型展现出的文化适应能力有利于全球化应用 在教育、创意辅助、客服等领域,这种"高性价比"模型可能会快速找到商业化突破口。 效率革命的新里程碑 小红书HI Lab开源的Dots.LLM1模型不仅为开源社区带来了新的选择,更重要的是展示了MoE架构在平衡性能与效率方面的巨大潜力。在算力成为AI发展瓶颈的今天,这种"少即是多"的设计哲学可能代表了大模型发展的一个重要方向。 对于行业从业者,我们有三个建议:1)

- 读取更多